Durante un suo intervento al LinuxCon 2009, l’ideatore e attuale maintainer del Kernel, ha sparato a zero circa l’attuale peso-forma del suo progetto.

![]()

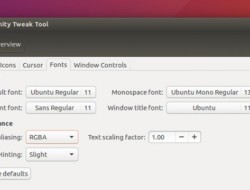

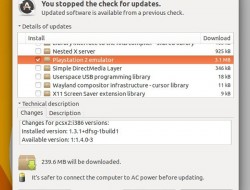

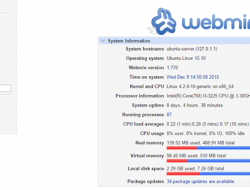

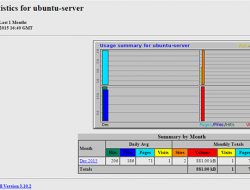

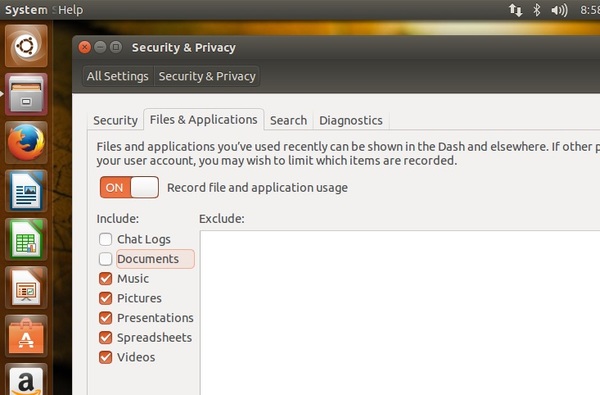

Forse c’è veramente qualcosa che non va nelle dimensioni del Kernel Linux se a criticarlo è lo stesso Linus Torvalds. In realtà il grande capo ha definito il pinguino gonfio e grosso. Talmente gonfio che è ormai impossibile prevedere qualsiasi intervento di recovery. La situazione, poi, diventa più preoccupante quando vengono mostrati alcuni dati statistici sulle performance del Kernel. Ebbene, forse non tutti sanno che ad ogni nuova versione calano del 2 per cento, con una riduzione complessiva di circa il 12 per cento nelle ultime 10 release. Tuttavia c’è qualcosa di cui andarne fieri, precisa Torvalds, ossia che gli sviluppatori trovano i bug con la stessa velocità con cui li implementano. “Sono un triste perché mi ritrovo difronte ad un kernel tutt’altro che piccolo, leggero e super-efficiente come lo avevo immaginato quindici anni fa”. Ed ora?

FONTE: Cnet

ARTICOLI CORRELATI:

- Microsoft: nuova crociata contro il pinguino

- Kernel Linux: gli sviluppatori aumentano del 10%

- Sviluppo Open: C e Java i più utilizzati

- Microsoft è in perdita, la colpa è dell’opensource